Дмитрий Силаев, ведущий маркетолог департамента продуктового маркетинга Холдинга Ingate

Дмитрий начал интересоваться поисковым продвижением и поисковыми технологиями еще в 2009 году, активно занимается SEO с конца 2010. Работу начал в январе 2011 в роли маркетолога. Менее чем за 1,5 года успел принять участие в разработке таких сервисов, как Rookee, , . Среди интересов — SEO, социальные сети и SMM, маркетинг, блоггинг, кино и активный отдых.

В рамках данной статьи я расскажу о том, как правильно анализировать своих конкурентов и, в частности, их обратные ссылки. Также вы узнаете, как можно использовать полученные данные для продвижения своих или клиентских проектов. И как, используя связку Ahrefs-Excel-Rookee, получить эффективную стратегию покупки ссылок. Известно, что использование стратегий, основанных на ссылочных паттернах («слепках») конкурентов, при прочих равных условиях (техническая и внутренняя оптимизация, удобство сайта для пользователя и д.р.) дает достаточно неплохой результат.

1. Анализ ссылочного паттерна конкурентов

Перед анализом конкурентов нам необходимо их определить. Для этого составим список запросов, по которым мы планируем продвигаться и искать конкурентов. Остановимся на нескольких запросах тематики «аренда грузовых автомобилей»:

- аренда грузовых автомобилей

- аренда грузовых автомобилей без водителя

- аренда грузовых автомобилей в москве

Частотность или конкурентность запросов не играет особой роли, методика анализа конкурентов, их ссылочной массы и последующее составление стратегий на основе полученных данных будет всегда одинаковой.

Для выбранных запросов необходимо проанализировать выдачу и определить сайты-конкуренты. Проще всего это сделать вручную, достаточно вбить эти запросы в Яндекс и собрать список url — адресов из ТОП10. После чего обработать полученный список в Excel и отобрать сайты, присутствующие в выдаче по указанным выше запросам.

Составив список конкурентов, необходимо избавиться от дублей. Получился вот такой список сайтов:

После того как список конкурентов по выдаче получен, нам необходимо получить для них обратные ссылки. Для этого мы используем сервис ahrefs.com, правда потребуется немного времени и терпения, для того, чтобы найти пересекающихся доноров у нашего списка сайтов.

Стоит отметить, что весь анализ построен на пересекающихся конкурентов. Все очень просто, список пересекающихся доноров поможет определить наиболее удачный ссылочный паттерн, я его называю «слепком», для которого впоследствии потребуется обозначить параметры. Параметры ссылок помогут при составлении стратегии покупки ссылок в Rookee. Данный метод применялся много раз и доказал свою состоятельность.

Как показывает практика, использование таких параметров, как , , наличие в каталогах и т.п., позволяет наилучшим образом охарактеризовать качество донора. Бытует мнение, что параметров сайта насчитывается более тысячи, но наиболее приемлемыми и эффективными считаются указанные выше. Также добавились новые параметры сайтов, например, трафик.

Итак, после того как мы составили список пересекающихся доноров, необходимо произвести проверку их параметров, воспользовавшись разнообразными специализированными сервисами или софтом. Я предпочитаю использовать простой скрипт, который проверяет следующие параметры доноров:

- тИЦ;

- PR;

- Наличие в Яндекс.Каталоге;

- Наличие в DMOZ;

- Количество страниц в индексе;

- Возраст домена (по whois и web-архиву).

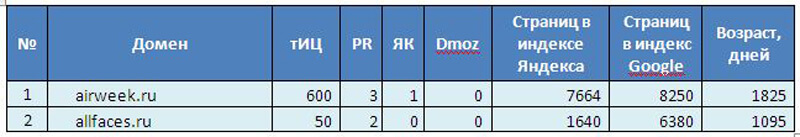

Получилась таблица со следующими значениями:

Всего в таблице получилось порядка 89 уникальных доменов с заполненными параметрами.

Первичная информация собрана, теперь займемся ее анализом. Как вы уже могли догадаться, анализировать будем параметры сайтов-доноров, описанные выше.

1. тИЦ сайтов-доноров. На данном графике наглядно показано, как распределяется тИЦ у сайтов-доноров. Показатель тИЦ у основной массы сайтов расположен в пределах от 0 до 90, максимальное же значение — 800.

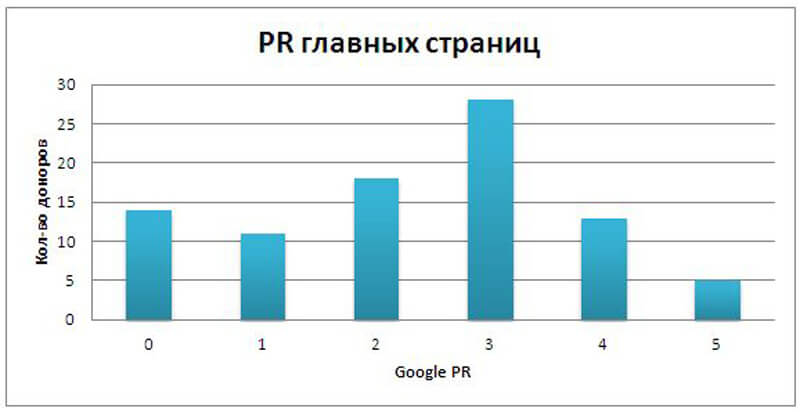

2. PR главных страниц. Значение PR главных страниц находится в диапазоне от 0 до 5, у большей же части доноров значение PR колеблется от 0 до 3.

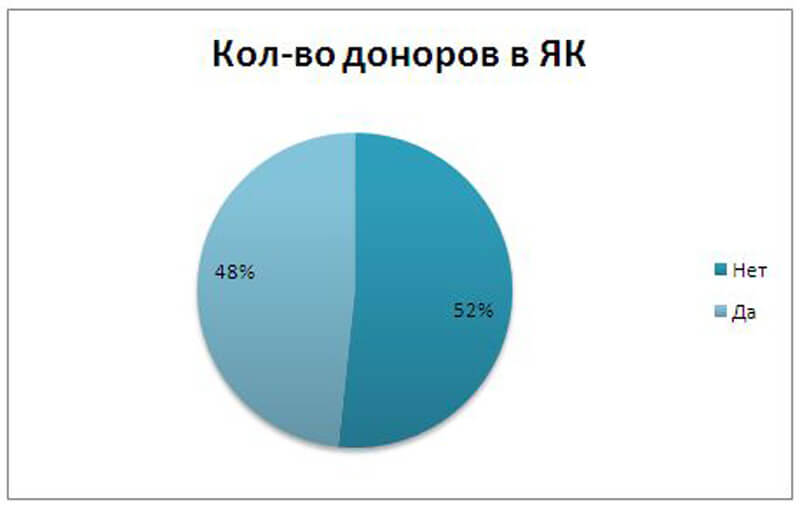

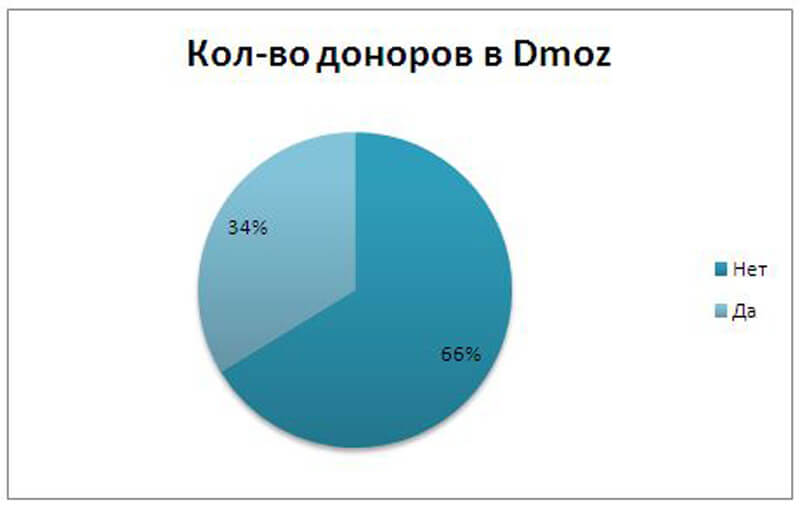

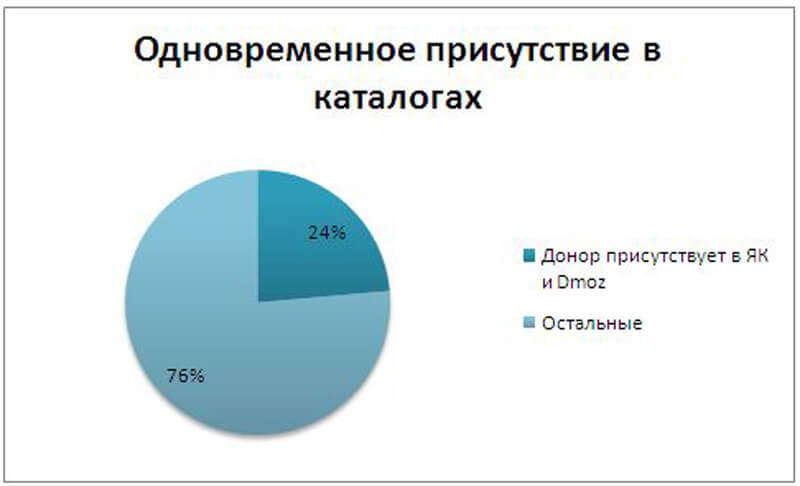

3. Присутствие доноров в каталоге Яндекса и DMOZ. Можно долго спорить, насколько важно нахождение сайтов-доноров в таких белых каталогах, как ЯК или DMOZ. По моему мнению, наличие донора в ЯКе или DMOZ не повредит, а возможно, сыграет и в плюс при продвижении. На приведенных ниже диаграммах видно, что 48% из пересекающихся доноров находится в ЯК и 34% в DMOZ. При этом 24% доноров одновременно находятся как в Яндекс.Каталоге, так и в DMOZ.

При этом 24% доноров одновременно находятся как в Яндекс.Каталоге, так и в DMOZ.

4. Доменная зона. Все доноры находятся в зоне RU.

5. Возраст доноров. На следующем графике вы можете увидеть распределение сайтов-доноров по возрасту домена. Информация о возрасте бралась как из данных Whois домена, так и из веб-архива. Как видно из графика, минимальный возраст доноров составляет 1 год, а максимальный — 13 лет. Причем возраст основной массы доноров находится в диапазоне от 1 года до 6 лет.

6. Количество страниц в индексе Яндекса и Google. Воспользуемся данными таблицы.

В ходе анализа количества страниц сайтов-доноров, находящихся в индексах Яндекса и Google, были выявлены следующие минимальные параметры:

- Страниц в индексе Яндекса — не менее 50;

- Страниц в индексе Google — не менее 50-150;

- Соотношение количества страниц в индексе Яндекса и Google — не менее 0,3 и не более 1,5.

7. Распределение доноров по УВ. Мой небольшой скрипт позволил получить не только параметры беклинков, но и распределить пересекающихся доноров по уровням вложенности. Это поможет более точно проанализировать ссылочную массу конкурентов и то, какие ссылки они покупают. На графике видно, что основная часть ссылочной массы куплена со страниц 2-го и 3-го уровня вложенности, но есть и ссылки со страниц 0 и 1 уровней. Данная информация позволит нам точно настроить фильтры покупки ссылок.

Когда вся собранная информация проанализирована, определены качественные параметры ссылочного паттерна, перейдем к созданию правил покупки ссылок. Об этом мы и поговорим в следующей части данной статьи.

2. Создание правил покупки ссылок в Rookee

Используя полученные ранее данные, мы теперь без особого труда можем создать свою стратегию покупки ссылок для сервиса Rookee. Составим сводную таблицу с полученными параметрами и их значениями.

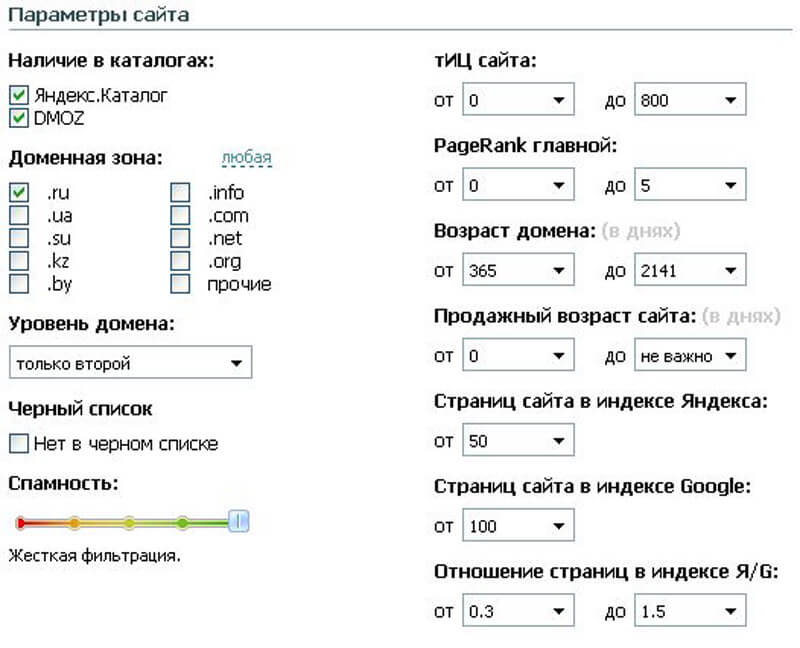

На зоне с настройками фильтрации ссылок необходимо заполнить следующие поля:

- Наличие в каталогах — ЯК и DMOZ;

- Доменная зона — ru;

- Уровень домена — второй;

- Спамность — максимальный уровень;

- тИЦ — от 0 до 800;

- PR главной — от 0 до 5;

- Возраст домена в днях — от 365 до 2141;

- Продажный возраст — от 0 до 2141;

- Страниц в индексе Яндекса — от 50;

- Страниц в индексе Google — от 100;

- Отношение страниц в индексе Я/G — от 0,3 до 1,5;

Для большей наглядности приведем скриншот из системы:

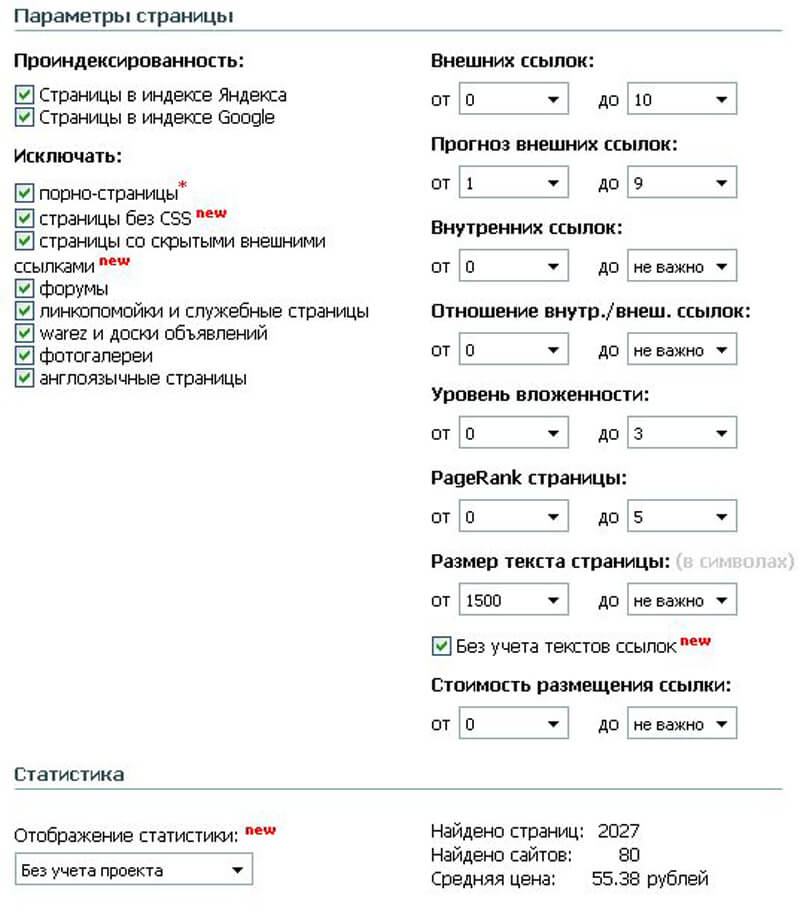

Итак, половина дела сделана, но не стоит забывать, что помимо параметров сайта, в Rookee есть еще и параметры страницы, которые также необходимо правильно настроить. Для параметров страницы необходимо установить следующие значения фильтров:

- Страницы в индексе Яндекса — да;

- Страницы в индексе Google — да;

- Исключать:

- порно-страницы;

- страницы без CSS;

- страницы со скрытыми внешними ссылками;

- форумы;

- линкпомойки и служебные страницы;

- warez и доски объявлений;

- фотогалереи;

- англоязычные страницы;

- Внешних ссылок — от 0 до 10 (ниже объясню, почему именно так);

- Прогноз внешних ссылок — от 1 до 9;

- Внутренних ссылок и отношение внутр./внеш. — не важно;

- Уровень вложенности — от 0 до 3;

- PageRank страницы — от 0 до 5;

- Размер текста страницы без учета текстов ссылок — от 1500 знаков.

Чтобы повысить качество продвигаемой ссылочной массы, включим максимальный уровень WL.

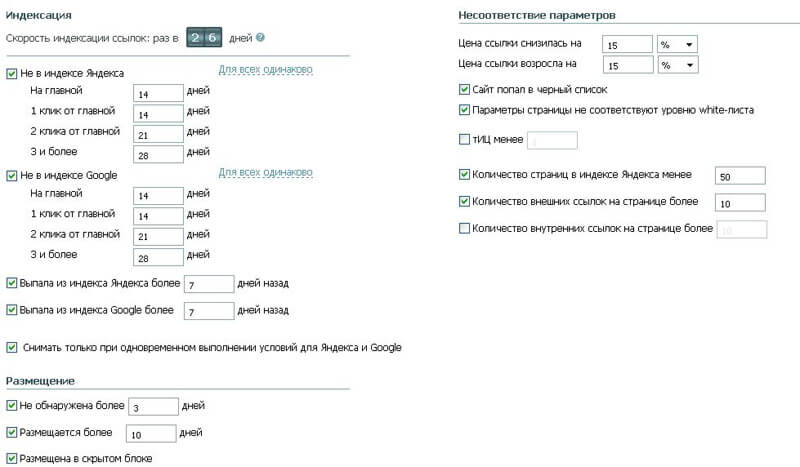

Наша стратегия почти готова. Осталось всего несколько штрихов, а именно добавить правила съема ссылок. Это необходимо для того, чтобы система автоматически следила за качеством ссылочной массы, и в случае снижения показателей купленных доноров — снимала такие ссылки. Только в этом случае наш ссылочный паттерн будет оставаться чистым и что самое главное, действующим.

Правила снятия настраиваем следующим образом:

- Не в индексе Яндекса:

- УВ 0 — 14 дней;

- УВ 1 — 14 дней; o УВ 2 — 21 дней;

- УВ 3 — 28 дней;

- Не в индексе Google: o УВ 0 — 14 дней;

- УВ 1 — 14 дней;

- УВ 2 — 21 дней;

- УВ 3 — 28 дней;

- Выпала из индекса Яндекса — более 7 дней назад;

- Выпала из индекса Google — более 7 дней назад;

- Снимать ссылку только при одновременном выполнении условий для Я и G — да;

- Ссылка не обнаружена — более 3 дней;

- Ссылка размещается — более 10 дней;

- Ссылка размещается в скрытом блоке — да;

- Сайт попал в черный список — да;

- Параметры страницы не соответствуют уровню WL — да;

- Количество страниц в индексе Яндекса — менее 50;

- Количество внешних ссылок — более 10 .

Теперь нашу стратегию для воссоздания ссылочного паттерна конкурентов можно смело использовать.

А теперь вопросы!

У вас наверняка мог возникнуть вопрос — почему, настраивая столь жесткие ссылки, мы выставили такие «большие» ограничения на количество внешних ссылок. Все довольно просто — ограничивать количество внешних ссылок я не стал, поскольку даже их большое количество будет нивелироваться получившимся качественным ссылочным паттерном.

Именно поэтому данный параметр не столь важен, да и в конечном итоге средняя стоимость ссылок, подобранных системой, и так получилась достаточно большой, а при наложении дополнительного фильтра на внешние ссылки средняя цена доноров возросла бы в несколько раз. Правила генерации анкоров я настроил по своему усмотрению. Вы же, используя все тот же Ahrefs, можете сделать выгрузку анкоров конкурентов и, используя функционал фильтрации Excel, проанализировать соотношение разных типов текстов. Стоит отметить, что задача непростая, но интересная.

Мы ехали — ехали и наконец приехали!

Отметим, что метод наращивания ссылочной массы как не лишен изъянов. Ссылочные паттерны не стоит считать 100% средством для вывода сайта в ТОП. Разумеется, при прочих равных переменных качественная ссылочная масса обеспечит устойчивый рост позиций, однако не стоит забывать, что идеальных слепков не бывает, и в конечном итоге, любой дубликат «ключа» может и не отпереть заветную дверь в ТОП поисковых систем. Однако использование подобного метода в качестве одной из составляющих обязательно поможет улучшить показатели вашего сайта.

Удачного вам продвижения!

Редакция Rookee

Редакция Rookee