В своем блоге SEOM.info я неоднократно касался параметров отсева сайтов, на которых мы покупаем ссылки. Так уж случилось, что я нахожусь по обе стороны баррикад - делаю сателлиты, а также занимаюсь продвижением клиентских ресурсов, в результате накопилось много информации, которая используется при продвижении сайтов и отсеве доноров.

Есть множество факторов, которые фигурируют среди основных критериев отсева:

- дубли контента;

- системные страницы;

- страницы с малым содержанием контента.

Среди дополнительных факторов существуют «субъективные» критерии для отсева:

- форумы;

- профили пользователей;

- варез/кино/порно.

Каждый сам для себя решает, по какой классификации обрабатывать ссылочную массу при покупке, но есть неоспоримые факты, которые свидетельствуют о том, что дублированный контент часто выпадает.

Системные страницы - это различные сортировки и прочая информация не несущая пользы, также поступают поисковики и с различными галереями и другими малоинформативными документами.

Выводы основаны на статистике выпадения страниц после апдейтов , работа ведется постоянно со ссылочным массивом 100+ тысяч ссылок на различных проектах, от клиентских, до сателлитов.

Все вышеописанные критерии вычисляются при большой выборке, при этом удается сократить процент выпавших страниц, после каждого апдейта, до 1-2% максимум (в диапазоне стоимости до 5 рублей за ссылку). Если говорить о более дорогих ссылках, то ситуация еще лучше здесь уже единичные выпадения.

Почему так важно делать качественный отсев доноров?

К покупным ссылкам все больше и больше требований, основное из них — это срок. Наша задача поставить ссылку надолго на качественном ресурсе, чтобы она принесла нам максимальный эффект. Если простоит 1 месяц или меньше, а донор уже выпадет, то это зря потраченные деньги.

Но на практике появился еще один фактор, который портил статистику и увеличивал процент выпавших сайтов, на которых покупались ссылки. Фактор довольно прост - бан или попадание под целой сети сайтов. При продвижении сайта по низкочастотным запросам мы покупаем довольно дешевые ссылки, которых нужно достаточное количество, для охвата большого семантического ядра, поэтому визуально мы не просматриваем сайты (кто просматривает сотни/тысячи сайтов ежедневно — респект, но не перегорите :)).

Возникла необходимость автоматического отсева стандартных сеток сайтов, которые сделаны не качественно и поддаются автоматическому анализу и вычислению. Сразу был откинут параметр просмотра whois данных и парсинга IP адреса, как не продуктивный.

В результате были вычислены параметры, автоматически определяющие распространенные сети сайтов на биржах.

Давайте посмотрим на результаты работы этих фильтров.

Каждый параметр проходит период тестирования, чтобы избежать случайного попадания не в «сеточный сайт», точность определения более 95% (да, все-таки порой случаются попадания не туда :)).

Для показа в статье были выбраны несколько распространенных сеток, данные по которым снимались 3 раза: 20.05.2010, 16.06.2010, 12.07.2010. Период в 2 месяца был выбран не случайно, как правило, дольше такие сайты не живут. Три контрольные точки были выведены как: вход в поисковой системы, начало выпадения страниц, попадание под АГС-фильтр или бан (даты соответствующие).

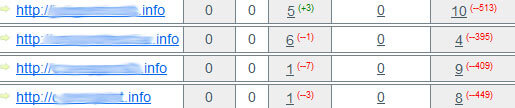

Результаты тестирования параметров (данные по первой и последней контрольной точке).

Нам интересны, прежде всего последние две колонки в статистических результатах (количество страниц в Яндексе и Гугле).

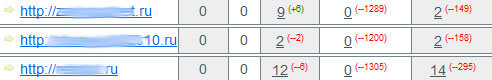

Сеть сайтов с базой данных по рефератам/курсовым/дипломным.

Результаты таковы:

По данным Яндекса - все испытуемые либо под АГС-фильтром, либо уже в бане.

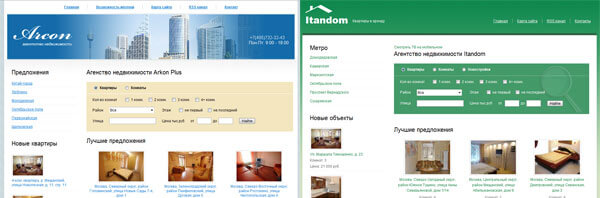

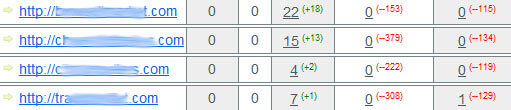

Сеть сайтов по недвижимости/квартирам.

Результаты таковы:

По данным Яндекса — все испытуемые либо под АГС-фильтром, либо уже в бане.

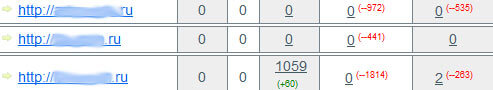

Сеть сайтов с базой данных предприятий по разным отраслям.

Результаты таковы:

По данным Яндекса — все испытуемые уже в бане.

Откровенные ГС медицинской тематики/скан книг/словари.

Результаты таковы:

По данным Яндекса — все испытуемые уже в бане.

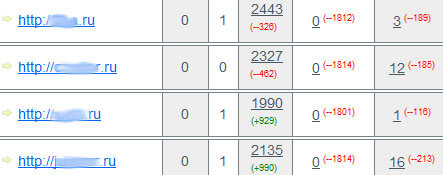

Сеть сайтов автомобильной тематики.

Результаты таковы:

По данным Яндекса — все испытуемые либо под АГС-фильтром, либо уже в бане.

Сеть сайтов не объединенная какой-либо тематикой, содержащая вполне приличные сайты.

Среди сетей сайтов встречаются и не совсем «поганые» и даже дорогие доноры, но суть от этого не меняется. Все они рано или поздно, а чаще — довольно рано, попадают под фильтры поисковых систем.

В результате, если мы закупили достаточно большой ссылочный массив на сетках сайтов, которые сделаны не качественно, то после очередного апдейта мы можем получить не 0,5-1% выпавших доноров, а все 10-20%.

Нужно ли говорить, что такие колебания ссылочной массы не доводят до добра?

Я думаю, не стоит пугать страшилками покупателей ссылок, но хотел бы заострить внимание не только на стандартных параметрах отсева сайтов, но и на «сеточном» признаке, который может оказать крайне негативное воздействие на процесс продвижения сайта.

В самое ближайшее время в сценариях системы ROOKEE появятся и мои наработки, которые позволят более четко обрабатывать ссылочный массив для продвижения низкочастотных запросов.

Александр Люстик (aka MyOST), руководитель ведущий блога SEOM.info.

Редакция Rookee

Редакция Rookee