На сегодняшний день основным методом поисковой оптимизации в рунете является покупка ссылок на биржах. Поисковые системы, не отрицая напрямую значимость покупных ссылок, продолжают активно бороться с линкоторговлей методом полного или частичного игнорирования ссылок, продающихся на биржах доноров.

Целью данного исследования является проверка факторов, прямо или косвенно влияющих на работоспособность донора, методом прямого анализа.

На данный момент у seo в Рунете существует несколько методов т.н. «анализа» донора на работоспособность. Перечислим их:

- Визуальная оценка донора;

- Фильтрация по контенту;

- Фильтрация по url;

- Фильтрация по пузомеркам;

- Фильтрация по исходящим/входящим ссылкам;

- Фильтрация по техническим характеристикам;

- Тестовые простановки.

Первый метод, особо любимый начинающими seo-специалистами, не выдерживает никакой критики, что, на наш взгляд, не имеет смысла доказывать.

Что представляет собой фильтрация по контенту? Допустим, в контенте содержится слово «порно». Можно предположить, что ссылка с этой страницы на обычный сайт будет довольно слабо котироваться. Эта же методика позволяет выбрасывать сети сайтов по некоторым шаблонным признакам.

Фильтрация по url - фактически, позволяет не покупать ссылки с доноров, у которых есть, например, стандартные ссылок.

Фильтрация по пузомеркам - это знает каждый - ТИц, количество исходящих и масса других параметров.

Фильтрация по исходящим - есть мнение, что если сайт ссылается на «плохие» сайты, то это плохой донор.

Фильтрация по техническим характеристикам - пример: если сайт содержит popup’ы, вирусы и т.п. вещи - то это опять же, с большой вероятностью, некачественный донор.

Таким образом, существует две методологии проверки работоспособности донора: те, в которых измеряется сам результат, и те, в которых результат предполагается (пускай и доказывается затем путем экспериментов на репрезентативной выборке). К первому типу относятся только тестовые простановки и в какой-то мере фильтрация по исходящим ссылкам - в некоторых случаях данную проверку можно использовать вместо тестовых простановок, но, к сожалению, довольно редко.

Все остальные методы - могут давать результат, но прямо недоказуемы. В случае их применения мы можем только предполагать, что они дадут результат.

О тестовых простановках поговорим подробнее.

Учитывая, что другие методы фильтрации либо объективно работают и уже реализованы в системе ROOKEE, либо совершенно недоказательны (визуальная проверка), нас интересовал в первую очередь именно этот, прямой метод измерения результата.

Вкратце о самой методологии, без раскрытия точного алгоритма. В качестве акцептора обычно применяется большой многостраничный, довольно старый сайт. На нем на части страниц находятся запросы, которые наличествуют в определенном диапазоне выдачи, при этом имеющие схожие диапазоны количества страниц в поиске. Затем с доноров по специальному алгоритму проставляются ссылки на эти страницы с определенным ранее ключом, и после индексации уровень работоспособности определяется по специальной методике.

В методе есть множество нюансов, касающихся кластеризации, ссылочных апов, подбора запросов и т.п., он очень дорогой (затрачиваются средства на покупку, причем далеко не одной ссылки с донора), но зато довольно хорошо реализуется алгоритмически, и после постановки на промышленные рельсы практически не требует затрат ручного труда, не считая, конечно, труда аналитиков.

Это все теория, перейдем к практике.

Для первоначального исследования нами была взята выборка из 50 000 сайтов. В результате проведенных тестовых простановок были получены следующие данные: часть ссылок со страницами выпала из , порядка 54% из всех оставшихся сайтов успешно прошли тестирование - то есть показали приемлемую работоспособность. Оставшаяся часть или совсем не работает, или затраты на ее анализ не стоят себестоимости по закупке и программному обслуживанию ссылок на ней.

После этого были проведены оценки небольшой выборки из работоспособной части по визуальной методике. Результаты, в принципе, были предсказуемы, но очень хотелось убедиться в том, что ожидали - довольно большой процент «некрасивых» сайтов хорошо, а местами и очень хорошо работает.

Теперь поговорим о сравнительной эффективности: загружено 80 сайтов из тестовой коллекции аналитического отдела сервиса ROOKEE, на которые было накуплено ссылок по 400 запросам (из которых 200 уникальные). На половину из них покупались ссылки со стандартными сценариями, на другую - со стандартными сценариями плюс с включенной закупкой только по полученному тестовыми простановками white-листу.

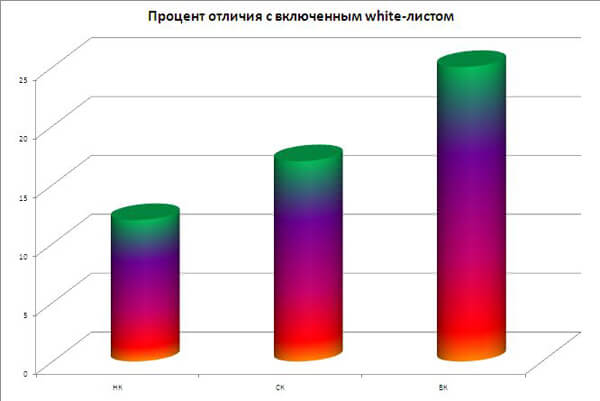

, т.к. тестовая коллекция была не идеальна, что-то попало под АГС, плюс из индекса пропала довольно существенная часть ссылок (об этом ниже), по остальным сайтам получены следующие данные: процент вывода с включенным white-листом на промежуточных срезах отличается от стандартного: по НК - на 12%, по СК - на 17%, по ВК - на 25%. В принципе, этого следовало ожидать, так как для ВК-запросов хорошие ссылки гораздо важнее, чем для НК.

Дополнительно была произведена закупка по 20 СЧ СК запросам с неработающих площадок. Как видно из графика, результат не просто мал а, скрорее, обратен ожидаемому; эффективность равна нулю (ни один из проектов не приблизился даже к топ50):

Кроме всего прочего возникла следующая проблема - примерно 15-20% ссылок ежемесячно пропадает из индекса. В вышеприведенном исследовании за три месяца пропало в районе 45% ссылок, что, мягко выражаясь, не удовлетворяет потребностям настоящего seo-специалиста. Про это - следующая часть.

Итак, как уже было сказано выше, одной из серьёзных проблем, с которой мы столкнулись при проведении исследования, стала проблема выпадения значительного числа тестовых ссылок из индекса, размещённых, казалось бы, на качественных донорах. Проблема была столь серьёзна, что ставила под вопрос саму идею составления нормального white-листа.

В основной своей массе ответственен за вылет ссылок из индекса небезызвестный «АГС-XX». Учитывая применяемую яндексом технологию «MatrixNET», отделом аналитики было решено попытаться решить проблему выбора доноров привлечением технологии нейронных сетей, зафиксировав для наблюдаемой выборки ограниченное множество характеризующих параметров. Аргументы просты: ввиду высокой сложности идентификации алгоритма ранжирования на основе статистических методов, хорошей альтернативой являются нейронные сети.

В качестве результата мы ожидали получение набора весов значимости характеризующих параметров, после чего было бы возможно получить вероятностную оценку работоспособности технологии на тестовых выборках сайтов.

Сеть была выполнена ациклической трёхслойной в соответствии с моделью Ворда общим числом в 520 узлов; при обучении использовались два классических подхода: метод обратного распространения ошибки и обучение с учителем. В структуру сети входили как пороговые, так и сигмоидные функции. Для обучения и последующего анализа сетью первоначально было отобрано 112 параметров, так или иначе характеризующих качество площадок. В число анализируемых входили и параметры, отражающие стабильность нахождения ссылок в индексе: время до индексации, среднее время выпадения из индекса, интервал между «морганиями», общее время нахождения в индексе, характеристики изменения ссылочной массы, включая её региональную составляющую и т.д.

Как показала практика работы с сетью в процессе её обучения, не все из принятых к рассмотрению параметров оказались значимыми и их удаление из рассмотрения (разумеется, при последующем переобучении сети и повторении цикла кросс-проверок) приводило к незначительным отклонениям в величинах оценки качества ресурсов. В результате, из исходных 112 был оставлен 61 параметр, 27 из которых относились к группе ссылочных характеристик, при этом колебания в величине оценки находились в интервале 7..13%, что является приемлемым для решения подобных задач.

Почти двукратное сокращение числа наблюдаемых параметров позволило обеспечить разумный компромисс: с одной стороны, мы существенно подняли скорость вычислений и анализа, с другой стороны — не проиграли в точности оценок. Для этой группы параметров и было выполнено полноценное обучение сети. Обучение проводилось на исторических данных за 2 месяца наблюдения, накопленных в общей сложности для 8215 площадок.

В результате обучения и последующей обработки пула были получены устойчиво наблюдаемые группы значений параметров, соответствующих высокой вероятности стабильности нахождения ссылок донора в индексе.

Интересно отметить следующую тенденцию: интенсивность влияния установленных групп параметров монотонно возрастает, что в целом обеспечивает более высокое качество фильтрации.

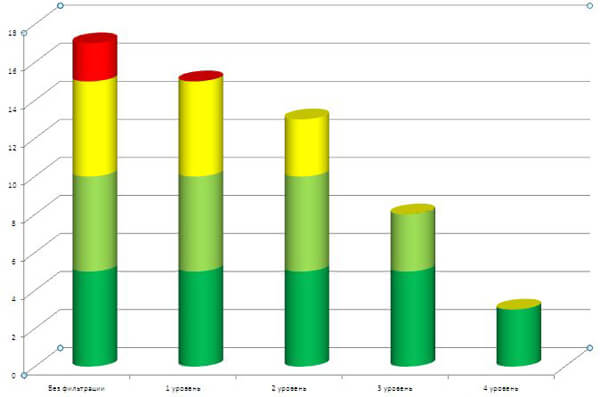

Среди множества вариантов кластеризации решений были отобраны четыре, обеспечивающие максимальное качество фильтрации. График ниже выражает зависимость вероятности выпадения ссылки из индекса Яндекса, как кумулятивную характеристику групп параметров (по мере роста жесткости увеличивается число параметров фильтрации).

Подводя итог проведенным исследованиям, можно сделать следующие выводы:

- Использовать фильтрацию тестовыми простановками эффективно не только в плане продвижения сайта, но и в экономическом плане;

- Метод машинного обучения фильтрации по техническим параметрам дает очень хорошее уменьшение «мигания» ссылочной массы.

Над материалом работали:

Сергей Панков, директор по исследованиям и разработке,

Михаил Кузьмин, директор по развитию,

Александр Салтыков, руководитель отдела проектирования,

Илья Куницкий, маркетолог,

Илья Зябрев, (aka G00DMAN).

Редакция Rookee

Редакция Rookee